Wie lässt sich Umweltpolitik intelligenter gestalten – und vor allem: wirklich effektiv? Die Antwort vieler Kommunen heißt: Mit Daten.

Denn wer in Zeiten von Hitzewellen, Starkregen und überhitzten Innenstädten gute Entscheidungen treffen will, braucht mehr als Erfahrung und Bauchgefühl.

Es braucht Informationen – und die im Idealfall aus vielen Quellen, vernetzt und mit hoher Qualität. Und wirklich smart wird es dann, wenn sie mehr liefern als nur punktuelle Momentaufnahmen, sondern konstant und “historisch” rückverfolgbar. Dann nämlich geben sie Aufschluss über Klimamuster, Risiken und Effekte von Maßnahmen. Genau hier kommen Smart Cities und Klimadashboards ins Spiel.

Denn sie machen sichtbar, was oft abstrakt bleibt, zum Beispiel:

• Wie sich Flächenentsiegelung auf Mikroklima auswirkt.

• Wo Hitzespots sind – und weshalb sie vielleicht entstehen.

• Und wie sich Niederschlagsereignisse in Echtzeit mit Pegel- und Bodenfeuchtedaten verknüpfen lassen, um besser vorbereitet zu sein.

Ein Blick nach Südwestfalen zeigt, wie Smart Cities mit Klimadaten arbeiten – und warum die Gestaltung dieser Datenflüsse inzwischen genauso wichtig ist wie der Ausbau der Sensoren-Dichte.

Was ist ein Klimadashboard – und was kann es leisten?

Ein Klimadashboard ist weit mehr als eine grafische Spielerei. Es ist das zentrale Steuerungsinstrument einer klimaresilienten Smart City. Es ist ein Digitaler Zwilling, in welchem Messdaten aus unterschiedlichen Quellen zusammenlaufen:

- Temperatur,

- Luftfeuchtigkeit,

- Niederschlagsmengen,

- Luftdruck,

- Beleuchtungsstärke und UV-Intensität,

- Bodenfeuchte,

- Versiegelungsgrad,

- Hitzebelastung –

- aber auch Daten zur Nutzung von Gründächern oder Entsiegelungsflächen.

Die Besonderheit: Diese Daten sind im Idealfall in Echtzeit verfügbar. Sie können verknüpft, verglichen und mit historischen Veränderungen in Beziehung gesetzt werden. So entstehen dynamische Karten und Zeitverläufe, die aus Informationen echte Entscheidungsgrundlagen machen.

Gute Dashboards unterscheiden zwischen Zielgruppen:

- Technische Auswertungen für Fachabteilungen,

- interaktive Karten für Bürgerinnen und Bürger,

- zusammenfassende Reports für politische Entscheidungsträger.

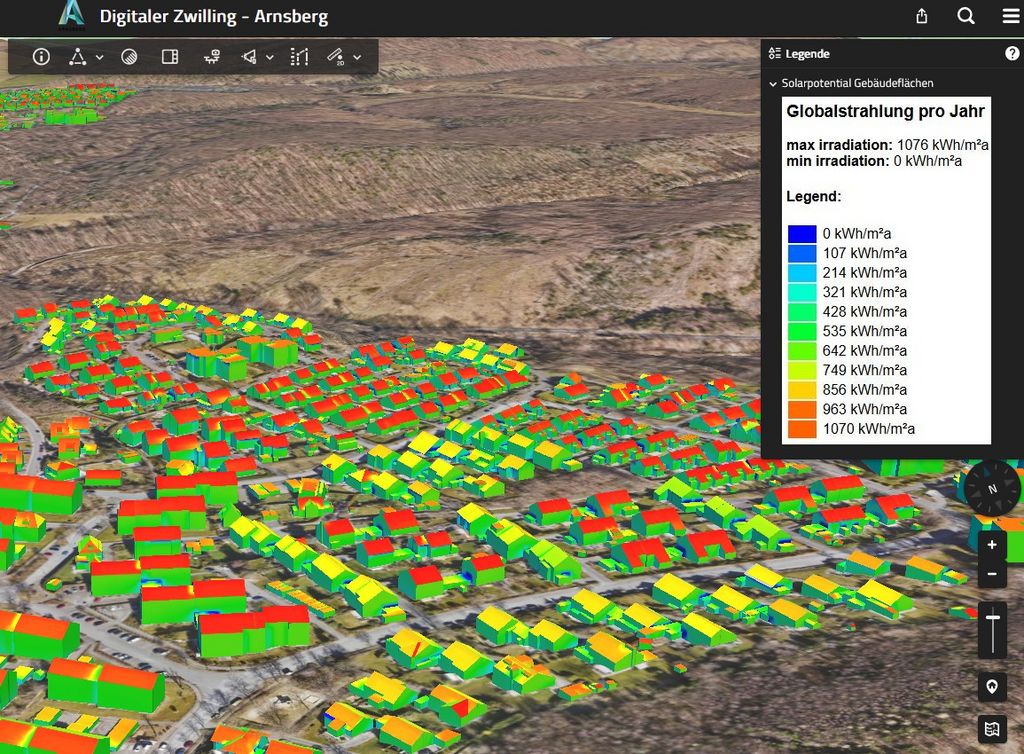

Ein Beispiel: Wenn eine Stadtverwaltung die Wirkung einer neuen Dachbegrünung nachvollziehen will, braucht sie verlässliche Daten zu Lufttemperatur, Oberflächenstruktur und Feuchtigkeit im Vergleich zur Umgebung. Nur so lassen sich politische Maßnahmen auch evaluieren.

Ein besonders ambitioniertes Beispiel liefert die Stadt Soest mit ihrem Projekt “Urban Climate Twin”. Ziel ist es, eine valide Datenbasis für das Soester Stadtklima zu schaffen und verschiedenste Datenquellen zu integrieren – darunter ein 3D-Stadtmodell, Flugzeug- und Satellitendaten sowie Daten aus dem Versiegelungskataster des Lippeverbandes. Diese Daten sollen in Simulationstools einfließen, um das Stadtklima realistisch zu modellieren.

Denn: Klimatologische Fragestellungen erfordern flächendeckende, permanente und langfristige valide Beobachtungen.

Bessere Daten, bessere Entscheidungen

Ein gutes Klimadashboard ist kein Prestige-Projekt. Es hat einen operativen Nutzen – und muss diesen auch einlösen. Sonst bleibt es ein digitales Schaufenster ohne Funktion.

Im besten Fall wird es zum täglichen Arbeitsmittel in Verwaltung und Politik:

- als Frühwarnsystem,

- als Monitoring-Tool und

- und als Entscheidungshilfe.

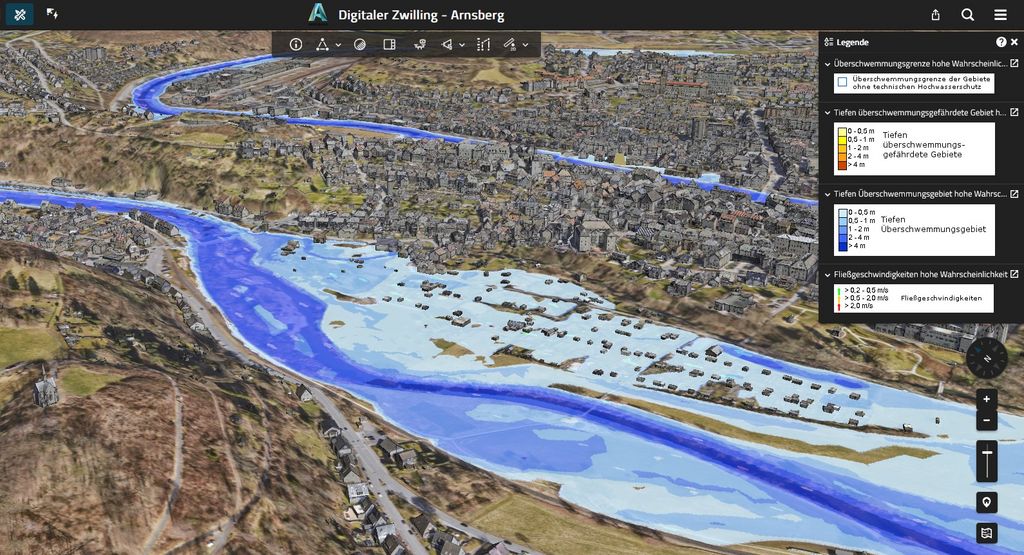

Beispielsweise kann es bei Starkregenereignissen eine Echtzeitanalyse liefern, indem es aktuelle Niederschlagsmengen mit Pegelständen in Flüssen und Kanälen verknüpft. So entstehen Frühindikatoren, die für den Bevölkerungsschutz entscheidend sein können.

Andere konkrete Anwendungsfälle können sein:

- Monitoring der Wirkung von Begrünung oder Entsiegelung

- Vergleich verschiedener Stadtteile hinsichtlich Hitzeentwicklung

- Ableitung von Handlungsbedarfen bei Trockenphasen oder Überhitzung

Ein anderes Beispiel: Wenn es in einem Stadtteil zu häufigen Hitzeproblemen kommt, kann das Dashboard helfen, die Ursachen sichtbar zu machen – etwa durch eine Kombination aus Oberflächentemperaturen, Versiegelungsgrad und Feinstaubbelastung. Darauf aufbauend lassen sich konkrete Maßnahmen planen, etwa zusätzliche Baumpflanzungen oder die Umgestaltung von Schulhöfen.

Bild: Das Klimadashboard der Stadt Arnsberg zeigt, welche Häuser von einem Hochwasser durch Überschwemmung betroffen wären. So kann sich die Planung darauf vorbereiten (Quelle: Stadt Arnsberg)

Smart wird’s erst, wenn Daten zu Entscheidungen führen

Doch operative Wirkung entsteht nur, wenn das Dashboard in interne Prozesse eingebunden ist. Es reicht nicht, die Daten öffentlich bereitzustellen. Vielmehr müssen Verwaltungsprozesse angepasst werden: Zuständigkeiten für das Monitoring definieren, Prozesse zur Reaktion auf bestimmte Schwellenwerte festlegen, regelmäßige Auswertungszyklen etablieren. Das Klimadashboard wird so zum aktiven Steuerungselement.

Auch politisch kann ein Dashboard Wirkung entfalten: Wenn Entscheidungsträger sehen, dass Begrünungsmaßnahmen messbare Effekte auf das Mikroklima haben, steigt die Bereitschaft zur Förderung solcher Maßnahmen. Gleichzeitig können Bürger*innen über öffentliche Visualisierungen besser nachvollziehen, wie und wo Maßnahmen greifen – was Akzeptanz und Beteiligung fördert.

Kurz: Ein Klimadashboard ermöglicht datenbasierte Umweltpolitik, die statt auf Annahmen auf Muster, Korrelationen und Trends reagiert.

Bild: Das Klimadashboard der Stadt Arnsberg zeigt, welche Hausdächer sich sehr gut für eine Photovoltaik-Anlage eignen (Quelle: Stadt Arnsberg)

Vom Sensor zur Strategie

Ein funktionierendes Dashboard basiert nicht nur auf Technik, sondern auf Struktur.

• Es braucht verlässliche Datenquellen: Dazu zählen etwa LoRaWAN-Sensoren, Daten des Deutschen Wetterdienstes, Satellitenbilder oder NetAtmo-Geräte von Privatpersonen. Viele dieser Daten sind frei verfügbar und können einfach integriert werden.

• Diese Daten müssen verknüpft werden – über offene Schnittstellen, mit einheitlicher Datenstruktur.

• Die Visualisierung muss zielgruppenorientiert erfolgen: Fachabteilungen brauchen andere Oberflächen als Bürger.

Und schließlich braucht es eine Stelle, die diese Datenflüsse dauerhaft managt: Wer liefert welche Daten? Wie ist die Datenqualität? Wie aktuell sind die Quellen? Wie wird mit Ausfällen umgegangen?

Auch in Arnsberg werden immer mehr Umwelt- und Klimadaten gebündelt. Das entstehende Klimadashboard verbindet klassische Klimadaten mit innovativen Messungen – etwa Sensoren im Arnsberger Wald, die über Lautstärke Biodiversität erfassen oder über Bodenfeuchte zur Hochwasserprävention beitragen. Das Ziel: passgenauere Projekte mit lokaler Wirkung auf Basis belastbarer Datengrundlagen.

En detail: Was es braucht, damit Dashboards wirken

1. Sensoren

Ein funktionierendes Dashboard basiert nicht nur auf Technik, sondern auf Struktur. Das beginnt bei der Auswahl der Sensoren: Günstige Low-Cost-Geräte lassen sich schnell und zahlreich installieren, haben aber oft eingeschränkte Genauigkeit. Professionelle Sensoren sind teurer, liefern aber stabilere Daten – und stellen weniger Aufwand bei der Wartung dar. Die Lösung liegt häufig im Mix: Wichtige Punkte werden professionell gemessen, andere durch Bürgersensorik ergänzt. Die Abweichung der günstigen Sensoren kann z.B. mittels einer KI anhand der hochqualitativen Referenzdaten (bspw. Thermalbefliegungen oder Satelliten-Bilder) konstant korrigiert werden. Doch egal, welche Geräte eingesetzt werden – die eigentliche Arbeit beginnt danach.

2. Datenmanagement

Datenmanagement ist die unsichtbare Grundlage jedes Dashboards. Ohne klare Standards, offene Schnittstellen und eine saubere Datenstruktur nützt selbst das beste Messnetz wenig. Viele Kommunen unterschätzen den Aufwand, der mit der Integration, Pflege und Aufbereitung der Daten verbunden ist. Unterschiedliche Formate, unvollständige Metadaten oder fehlende Aktualisierungen führen schnell zu einem Daten-Wirrwarr, das mehr Fragen aufwirft als beantwortet.

Deshalb ist es entscheidend, dass schon in der Planungsphase die IT-Abteilung und mögliche Datenverantwortliche eingebunden werden. Fragen wie: „Wo werden die Daten gespeichert?“, „Wer ist für die Qualitätssicherung verantwortlich?“ oder „Wie sehen Backup- und Aktualisierungsprozesse aus?“ müssen frühzeitig geklärt werden. Nur dann entsteht eine Architektur, die langfristig tragfähig ist.

3. Kompetenzen

Darüber hinaus braucht es Menschen, die diese Datenflüsse steuern. Mehrere Kommunen berichten, dass sie langfristig eine eigene Organisationseinheit für Datenmanagement benötigen – mindestens zwei bis drei Personen, die sich ausschließlich um das Sammeln, Prüfen und Strukturieren von Klimadaten kümmern. Hinzu kommt oft eine Art „Dateninventur-Team“, das bereichsübergreifend erfasst, welche Daten bereits vorhanden sind – häufig verstreut in Fachabteilungen oder bei externen Partnern.

Ein weiterer Knackpunkt: Die Visualisierung. Unterschiedliche Zielgruppen haben unterschiedliche Anforderungen. Ein Fachplaner benötigt andere Ansichten und Datenzugänge als ein interessierter Bürger oder eine politische Entscheidungsträgerin. Gute Dashboards erkennen diese Unterschiede an – und schaffen unterschiedliche Einstiegsebenen, die jeweils relevante Informationen sichtbar machen, ohne zu überfordern.

Praxisbeispiele aus der Region: Soest, Arnsberg, Münster

Soest hat mit dem Projekt Urban Climate Twin ein Vorzeigeprojekt entwickelt: Ein stadtweites Sensorennetz liefert Daten zu Temperatur und Feuchtigkeit, die mit Hilfe einer KI korrigiert werden. Zusätzlich fließen Satellitendaten ein. Ziel ist, kleinräumige Aussagen über das Stadtklima treffen zu können – und die Wirkung von Maßnahmen wie Flächenentsiegelung nachweisen zu können. Die Ergebnisse sollen langfristig als strategische Grundlage für Klimaanpassung dienen.

Auch Arnsberg arbeitet mit bestehenden Netzen und bürgerbasierten Sensoren. Der Clou: Viele Daten liegen bereits vor – etwa von privaten Wetterstationen oder NetAtmo-Geräten. Diese werden über offene Schnittstellen eingebunden, um ein flächendeckendes Bild zu bekommen. Auch hier liegt der Fokus auf Nutzung, nicht auf Maximal-Technik. Zudem erhalten nun interessierte Bürger Sensoren, welche sie an ihren Sattel anbringen können und so während Fahrrad-Fahrten durch die Stadt wertvolle Live-Daten liefern.

Münster hat frühzeitig auf öffentlich sichtbare Dashboards gesetzt und damit Bürgerkommunikation wie Facharbeit verbunden. Die Stadt zeigt, wie man öffentliche Daten auch als Instrument für Transparenz und Beteiligung denken kann.

Erfahrungen aus den Projekten: Das sollte man beim Aufbau eines Klimadashboards beachten

Mindestens zwei Projekte aus den 5 für Südwestfalen sammeln Erfahrugnen mit Klimadashboards. In Olpe gibt es zudem ein Hochwasser-Warnsystem.

Wir haben einige der Erfahrungen aus den Projekten zusammengetragen, um anderen Kommunen den Aufbau eines eigenen Klimadashboards zu erleichtern

1. Niederschwellig starten, aber Qualität nicht vergessen

Lieber mit günstigen Sensoren (ca. 150€) beginnen als gar nicht – professionelle Sensoren kosten 2.000-2.500€. Natürlich gibt es Qualitätsunterschiede – aber diese können bspw. durch KI und Abgleich mit Referenzdaten ausgeglichen werden. Lücken können später nachgerüstet werden.

2. Bestandsaufnahme als erster Schritt – und weitere Datenschätze anzapfen

Oft wird unterschätzt, wie viele Daten bereits vorhanden sind. Denn: Viele Bürger erheben mit privaten Wetterstationen schon viele Daten. Diese Daten sind über Plattformen wie NetAtmo bereits verfügbar. Auch gibt es bereits kostenfreie Daten im Internet.

Hier gibt es zum Beispiel eine Übersicht des Bundes, welche Geodaten frei verfügbar sind: https://gdz.bkg.bund.de/index.php/default/open-data.html

Aber auch Geosatelliten fliegen regelmäßig über Deutschland und liefern Daten.

Hier sind zwei wichtige Vertreter:

1. Copernicus (EU)

- Trägerschaft: Europäische Kommission + ESA (European Space Agency)

- Zentrale Satellitenreihe: Sentinel

- Sentinel-2: hochauflösende optische Aufnahmen (Vegetation, Bodenbedeckung, Flächenversiegelung)

- Sentinel-5P: Luftqualität (NO₂, O₃, CO etc.)

- Sentinel-3: Oberflächentemperatur und Meeresdaten

- Zugriff: öffentlich und kostenfrei über folgende Seiten https://www.copernicus.eu/de/zugang-zu-copernicus-satellitendaten sowie https://www.d-copernicus.de/daten/datenzugang/

2. Landsat-Programm (USA)

- Trägerschaft: NASA + USGS (United States Geological Survey)

- Typ: Multispektrale Erdbeobachtung seit 1972

- Nutzung: Langzeitvergleiche, Temperaturverläufe, Vegetationsanalysen

- Aktuelle Satelliten: Landsat 8, Landsat 9

- Zugriff: öffentlich über https://earthexplorer.usgs.gov/

3. IT frühzeitig einbinden

Die Integration der Daten ist ein häufiger Flaschenhals im Ablauf, deshalb ein wichtiger Tipp: Frühzeitig klären, wie Wetterstationen in städtische IT eingebunden werden. Auch die IT früh im Prozessablauf mit ihrem Know-How einzubinden, ist eine Empfehlung aus den Projekten. Generell muss man selbst kein:e ITler:in sein – viel wichtiger wird ein Verständnis für (Geo)Daten angesehen. Im Gesprächskreis der NRW Kommunen zum Thema sind bspw. Großteils Geoinformatiker.

4. Wartung und Betrieb nicht unterschätzen

Der Wartungsaufwand wurde gelegentlich vor dem Projektbeginn unterschätzt – und es stellte sich heraus, dass manche Sensoren eigentlich alle 14 Tage gereinigt werden müssten. Diese Kosten sollte man unbedingt auf dem Schirm haben.

5. Bürger einbinden

Eine 50/50-Mischung aus öffentlichen und privaten Sensoren hat sich bewährt. Innovative Ansätze wie Sensoren an Bürger Fahrrädern können Datenlücken schließen (diesen Weg eght man zum Beispiel in Arnsberg). Es könnte auch eine Idee sein, kommunale Fahrzeuge (bspw. von der Müllabfuhr) mit ähnlichen mobilen Sensoren auszustatten. Bürgerfeedback hilft bei der Qualitätssicherung

Fazit: Gut – wenn es gut gemacht wird. Und gut genutzt.

Klimadashboards sind kein Selbstzweck. Sie werden dann relevant, wenn sie in den Alltag der Stadtverwaltung integriert sind – als Planungsgrundlage, Monitoring-Werkzeug und Entscheidungsbasis.

Sie machen Smart Cities nicht nur technisch smarter, sondern auch politisch reaktionsfähiger. Und sie helfen, komplexe Zusammenhänge sichtbar zu machen, die bisher oft unter dem Radar blieben.

Damit das gelingt, braucht es nicht nur Sensoren und Software – sondern Menschen, die Daten einordnen, interpretieren und in Verwaltungshandeln übersetzen. Erst dann wird aus smarter Technik eine wirklich kluge Umweltpolitik.

Kurz: Ein Klimadashboard wirkt nicht automatisch – aber es kann. Nämlich dann, wenn es gut gemacht ist, aktiv genutzt wird und in konkrete Abläufe integriert ist. Dann ist es nicht nur ein Projektabschluss, sondern ein Startpunkt für datenbasierte Umweltpolitik.

Hilfreiche Links

- Zum Digitalen Zwiling aus Soest

- zum Digitalen Zwilling aus Menden

- zum Digitalen Zwilling aus Arnsberg

- Ein Grundlagentext des Bundesministerium für Wirtschaft & Energie zu Digitalen Energie-Zwillingen

- Ein Text aus dem Smart City Dialog , wie Digitale Zwillinge bei der Wärmewende helfen (Stichwort: Wärmeplanungs-Gesetz)